group-telegram.com/ai_machinelearning_big_data/7319

Last Update:

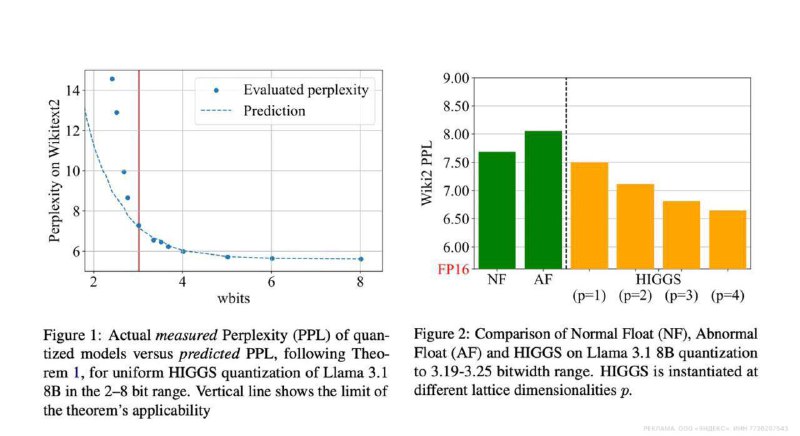

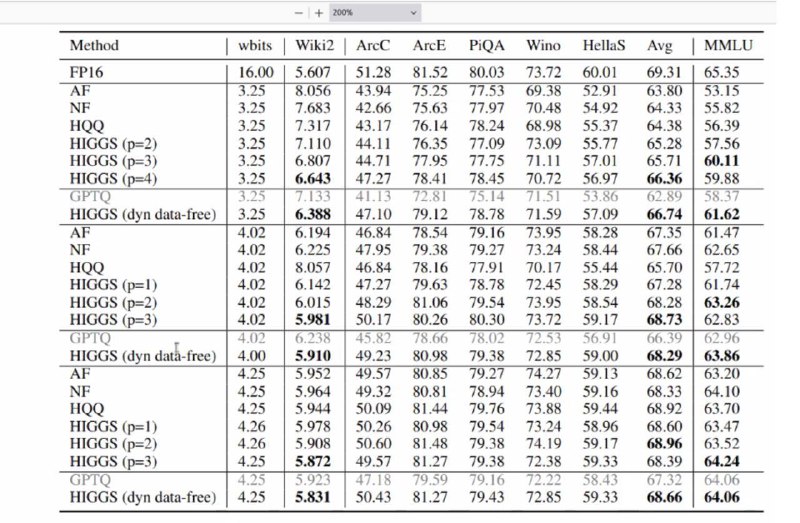

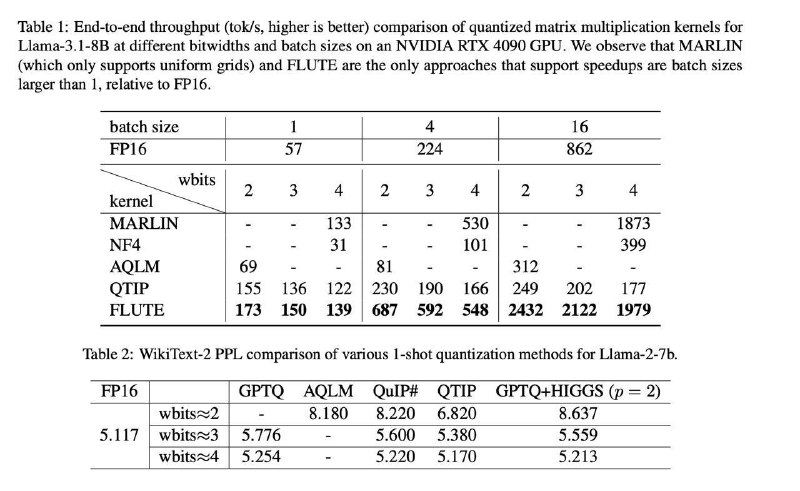

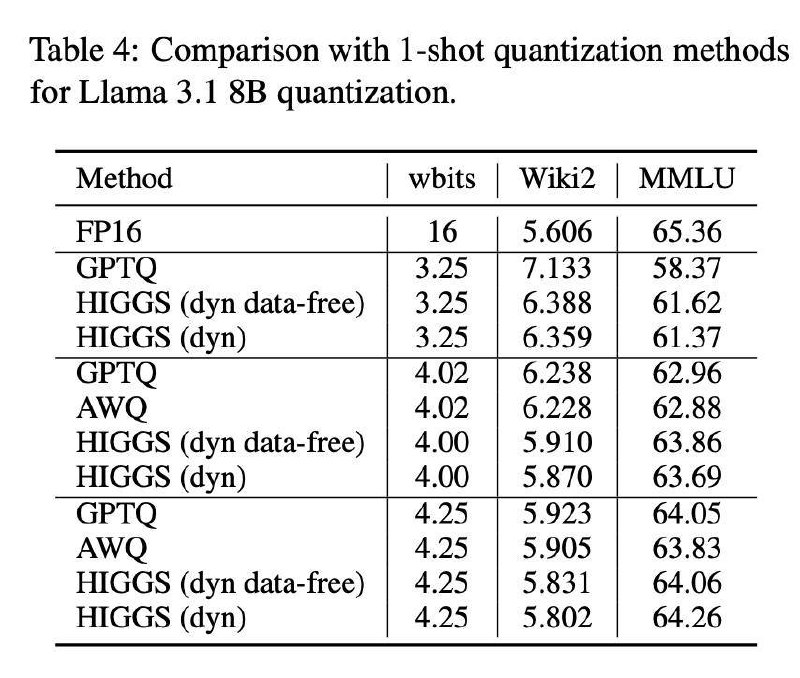

Недавно был представлен HIGGS (Hadamard Incoherence with Gaussian MSE-optimal GridS) — data-free метод квантизации, который позволяет запускать большие языковые модели локально, за минуты, без GPU.

Применение:

🛠 Установка:

pip install flute-kernel

python

from transformers import AutoModelForCausalLM, AutoTokenizer, HiggsConfig

model = AutoModelForCausalLM.from_pretrained(

"google/gemma-2-9b-it",

quantization_config=HiggsConfig(bits=4),

device_map="auto",

)

@ai_machinelearning_big_data

#quantization #LLM #opensource #HIGGS #ai