group-telegram.com/gentech_lab/26

Last Update:

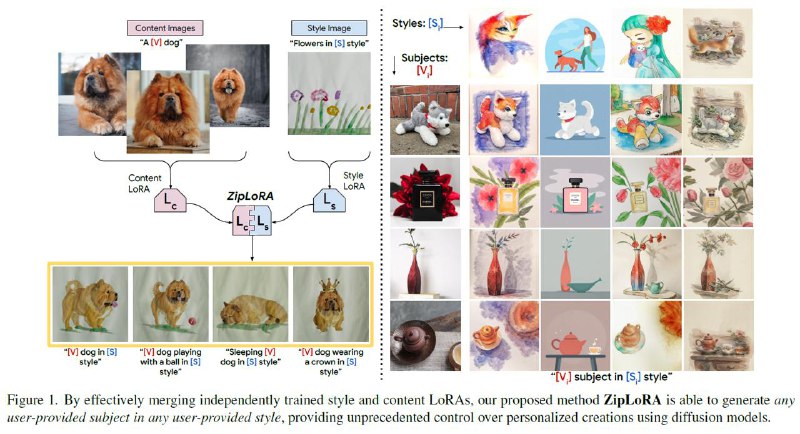

ZipLoRA: Any Subject in Any Style by Effectively Merging LoRAs #paper

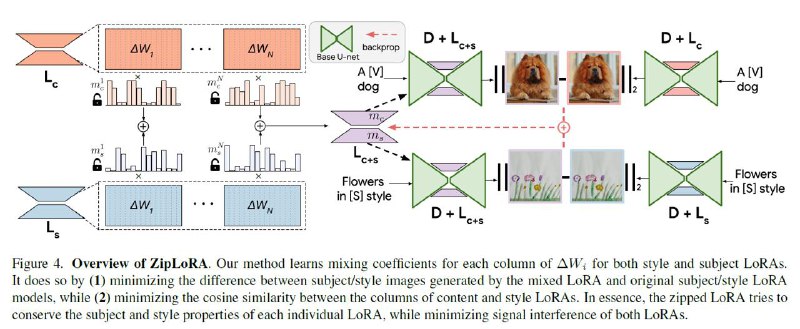

Статья от Google (ноябрь 2023), генерация картинок с заданными объектами в заданном стиле. На архитектуре SD XL. Используется механизм LoRA, добавляя лора-слои к каждому attention блоку исходной архитектуры. Причем в инференсе используются одновременно 2 обученных матрицы - одна для объекта, другая - для стиля. Используется тот факт, что после дообучения - матрицы LoRA являются сильно разреженными (можно без ущерба для качества - выбросить до 90% околонулевых коэффициентов).

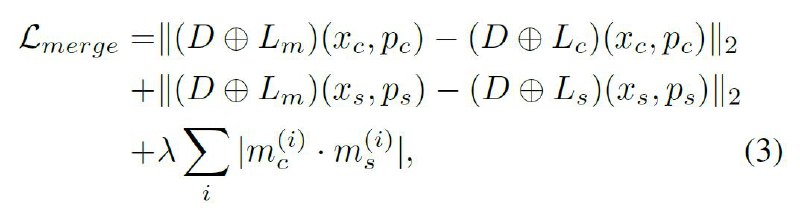

Вводится дополнительный этап обучения, когда 2 заранее обученных матрицы встраиваются друг в друга так, чтобы не затирать значимые коэффициенты друг друга. Для этого строится специальный loss: а) первые две части лосса заставляют результирующую матрицу предсказывать стиль как можно ближе к матрице стиля, а объект - как можно ближе к матрице объекта. b) третья часть - уменьшает косинусную близость соединяемых матриц.

Технически, LoRA матрицы объекта и стиля абсолютно одинаковы. Разница только в промптах для их обучения и слияния. Матрицы объекта учатся на промптах по типу "A <c> <class>", например "A <v12> dog". А матрицы стиля - на промпт "A picture in <s> style". И на таких же промптах - учится их слияние.

Декларируется, что для выучивания стиля достаточно одной референсной картинки.

📜Paper

@gentech_lab