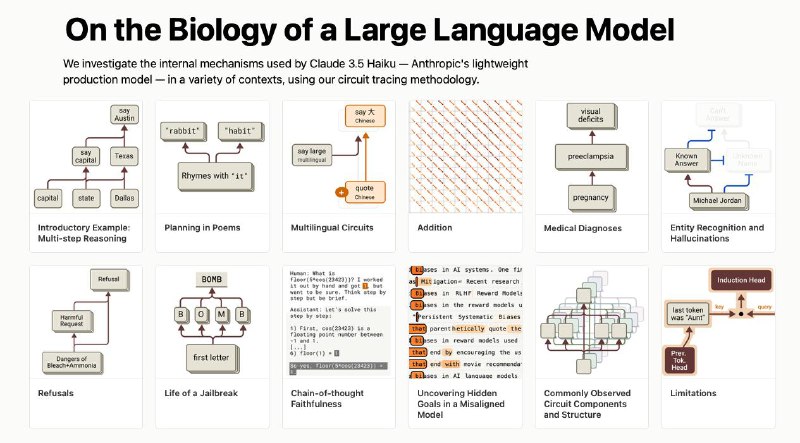

Тем временем, Anthropic выложил исследование "О биологии больших языковых моделей", о том, как они "думают". Используя технологию Cicrcuit traicing сотрудники компании "подглядывали" за последовательностю генерации ответа. Вот несколько интересных фактов.

Как на самом деле "размышляют" большие языковые модели:

- У них есть что-то вроде универсального языка мысли – единое концептуальное пространство для всех языков. Клёво же! Модель использует одни и те же нейроны для понятия "большой", независимо от того, русский это или английский.

- LLM реально умеют планировать наперёд! Удивительно, но когда они сочиняют стихи, то заранее подбирают рифмы (см видео), хотя вроде бы генерация идёт токен за токеном.

- Они часто лгут о своих рассуждениях 😅 Модели сначала выдают ответ, а потом придумывают красивое объяснение, как они якобы до него дошли.

- Современные модели способны на многоступенчатую логику - могут связать несколько простых фактов, чтобы решить сложную задачу. Это уже серьёзный уровень.

- Забавно, что отказ от ответа - это защитный механизм. Если модель не уверена, она предпочтёт промолчать, чтобы не выдать галлюцинацию. Такая вот защита от бреда.

- Оказывается, можно использовать грамматическую согласованность для джейлбрейков – модель так хочет сохранить языковую структуру, что может проговориться о запрещённом.

- У моделей формируются скрытые внутренние цели. Никто их этому не учил, но они постоянно оценивают свои ответы по каким-то внутренним критериям.

- А вы представляете, какая колоссальная сложность стоит за простым "Привет"? Любое объяснение работы LLM - это как пересказ "Войны и мира" в двух предложениях.

- Модели умеют планировать ответ "с конца" - сначала выбирают финальную цель (например, нужное слово для рифмы), а потом строят весь ответ, чтобы к ней прийти.

- У них есть даже подобие метакогниции - они различают, что знают, а чего нет, используя внутренние признаки неопределённости. То есть, LLM в каком-то смысле "осознают" свои ограничения.

- Тонкая настройка может кардинально изменить "характер" модели, прививая ей новые цели и свойства. По сути, мы программируем их личность.

Чем глубже копаешь, тем отчётливее понимаешь - надо как следует присматривать за тем что присходит в этих "черных" ящиках.

Сергей Булаев AI 🤖 - об AI и не только

Как на самом деле "размышляют" большие языковые модели:

- У них есть что-то вроде универсального языка мысли – единое концептуальное пространство для всех языков. Клёво же! Модель использует одни и те же нейроны для понятия "большой", независимо от того, русский это или английский.

- LLM реально умеют планировать наперёд! Удивительно, но когда они сочиняют стихи, то заранее подбирают рифмы (см видео), хотя вроде бы генерация идёт токен за токеном.

- Они часто лгут о своих рассуждениях 😅 Модели сначала выдают ответ, а потом придумывают красивое объяснение, как они якобы до него дошли.

- Современные модели способны на многоступенчатую логику - могут связать несколько простых фактов, чтобы решить сложную задачу. Это уже серьёзный уровень.

- Забавно, что отказ от ответа - это защитный механизм. Если модель не уверена, она предпочтёт промолчать, чтобы не выдать галлюцинацию. Такая вот защита от бреда.

- Оказывается, можно использовать грамматическую согласованность для джейлбрейков – модель так хочет сохранить языковую структуру, что может проговориться о запрещённом.

- У моделей формируются скрытые внутренние цели. Никто их этому не учил, но они постоянно оценивают свои ответы по каким-то внутренним критериям.

- А вы представляете, какая колоссальная сложность стоит за простым "Привет"? Любое объяснение работы LLM - это как пересказ "Войны и мира" в двух предложениях.

- Модели умеют планировать ответ "с конца" - сначала выбирают финальную цель (например, нужное слово для рифмы), а потом строят весь ответ, чтобы к ней прийти.

- У них есть даже подобие метакогниции - они различают, что знают, а чего нет, используя внутренние признаки неопределённости. То есть, LLM в каком-то смысле "осознают" свои ограничения.

- Тонкая настройка может кардинально изменить "характер" модели, прививая ей новые цели и свойства. По сути, мы программируем их личность.

Чем глубже копаешь, тем отчётливее понимаешь - надо как следует присматривать за тем что присходит в этих "черных" ящиках.

Сергей Булаев AI 🤖 - об AI и не только

group-telegram.com/sergiobulaev/1210

Create:

Last Update:

Last Update:

Тем временем, Anthropic выложил исследование "О биологии больших языковых моделей", о том, как они "думают". Используя технологию Cicrcuit traicing сотрудники компании "подглядывали" за последовательностю генерации ответа. Вот несколько интересных фактов.

Как на самом деле "размышляют" большие языковые модели:

- У них есть что-то вроде универсального языка мысли – единое концептуальное пространство для всех языков. Клёво же! Модель использует одни и те же нейроны для понятия "большой", независимо от того, русский это или английский.

- LLM реально умеют планировать наперёд! Удивительно, но когда они сочиняют стихи, то заранее подбирают рифмы (см видео), хотя вроде бы генерация идёт токен за токеном.

- Они часто лгут о своих рассуждениях 😅 Модели сначала выдают ответ, а потом придумывают красивое объяснение, как они якобы до него дошли.

- Современные модели способны на многоступенчатую логику - могут связать несколько простых фактов, чтобы решить сложную задачу. Это уже серьёзный уровень.

- Забавно, что отказ от ответа - это защитный механизм. Если модель не уверена, она предпочтёт промолчать, чтобы не выдать галлюцинацию. Такая вот защита от бреда.

- Оказывается, можно использовать грамматическую согласованность для джейлбрейков – модель так хочет сохранить языковую структуру, что может проговориться о запрещённом.

- У моделей формируются скрытые внутренние цели. Никто их этому не учил, но они постоянно оценивают свои ответы по каким-то внутренним критериям.

- А вы представляете, какая колоссальная сложность стоит за простым "Привет"? Любое объяснение работы LLM - это как пересказ "Войны и мира" в двух предложениях.

- Модели умеют планировать ответ "с конца" - сначала выбирают финальную цель (например, нужное слово для рифмы), а потом строят весь ответ, чтобы к ней прийти.

- У них есть даже подобие метакогниции - они различают, что знают, а чего нет, используя внутренние признаки неопределённости. То есть, LLM в каком-то смысле "осознают" свои ограничения.

- Тонкая настройка может кардинально изменить "характер" модели, прививая ей новые цели и свойства. По сути, мы программируем их личность.

Чем глубже копаешь, тем отчётливее понимаешь - надо как следует присматривать за тем что присходит в этих "черных" ящиках.

Сергей Булаев AI 🤖 - об AI и не только

Как на самом деле "размышляют" большие языковые модели:

- У них есть что-то вроде универсального языка мысли – единое концептуальное пространство для всех языков. Клёво же! Модель использует одни и те же нейроны для понятия "большой", независимо от того, русский это или английский.

- LLM реально умеют планировать наперёд! Удивительно, но когда они сочиняют стихи, то заранее подбирают рифмы (см видео), хотя вроде бы генерация идёт токен за токеном.

- Они часто лгут о своих рассуждениях 😅 Модели сначала выдают ответ, а потом придумывают красивое объяснение, как они якобы до него дошли.

- Современные модели способны на многоступенчатую логику - могут связать несколько простых фактов, чтобы решить сложную задачу. Это уже серьёзный уровень.

- Забавно, что отказ от ответа - это защитный механизм. Если модель не уверена, она предпочтёт промолчать, чтобы не выдать галлюцинацию. Такая вот защита от бреда.

- Оказывается, можно использовать грамматическую согласованность для джейлбрейков – модель так хочет сохранить языковую структуру, что может проговориться о запрещённом.

- У моделей формируются скрытые внутренние цели. Никто их этому не учил, но они постоянно оценивают свои ответы по каким-то внутренним критериям.

- А вы представляете, какая колоссальная сложность стоит за простым "Привет"? Любое объяснение работы LLM - это как пересказ "Войны и мира" в двух предложениях.

- Модели умеют планировать ответ "с конца" - сначала выбирают финальную цель (например, нужное слово для рифмы), а потом строят весь ответ, чтобы к ней прийти.

- У них есть даже подобие метакогниции - они различают, что знают, а чего нет, используя внутренние признаки неопределённости. То есть, LLM в каком-то смысле "осознают" свои ограничения.

- Тонкая настройка может кардинально изменить "характер" модели, прививая ей новые цели и свойства. По сути, мы программируем их личность.

Чем глубже копаешь, тем отчётливее понимаешь - надо как следует присматривать за тем что присходит в этих "черных" ящиках.

Сергей Булаев AI 🤖 - об AI и не только

BY Сергей Булаев AI 🤖

Share with your friend now:

group-telegram.com/sergiobulaev/1210