group-telegram.com/tech_priestess/2091

Last Update:

В последнее время в статьях про дообучение LLM на решение математических задач и прочий reasoning намечается тренд на экстремальное уменьшение размеров датасетов при экстремальном увеличении их качества. Так, в статье s1: Simple test-time scaling ( https://arxiv.org/abs/2501.19393 ) используется fine-tuning на 1000 примерах, в Less Is MOre for reasoning ( https://arxiv.org/abs/2502.03387 ) - на 817... куда же заведет эта дорожка? Сегодня утром я совершенно внезапно для себя нашла ответ: проснулась, потянулась, проверила список Huggingface Daily Papers за 30 апреля

...Reinforcement Learning for Reasoning in Large Language Models with

Авторы утверждают, что их RL на одном примере позволяет очень сильно улучшить качество решения математических датасетов маленькими моделями - Qwen2.5-Math-1.5B (результат см. на рис. 1), а также Qwen2.5-Math-7B, DeepSeek-R1-Distill-Qwen-1.5B и, в некоторой степени, Llama3.2-3B-Instruct. Но есть несколько нюансов:

Во-первых, для того, чтобы найти тот самый пример-бриллиант, от которого умственные способности моделей засветятся синими лучами

Во-вторых, чтобы отобранный пример действительно улучшил качество модели, на нем придется сделать около 1000-2000 итераций (повторение - мать учения?

В-третьих, чудо-пример, найденный с помощью Qwen2.5-Math-1.5B, хоть и более-менее переносит свои волшебные качества на два других квена, но не так хорошо переносится на Llama (у той увеличение качества в среднем оказалось всего около 2%, см. рис. 2 для подробностей).

Тем не менее, заявление авторов статьи звучит сильно, и будет очень интересно, если кто-нибудь сможет его независимо подтвердить.

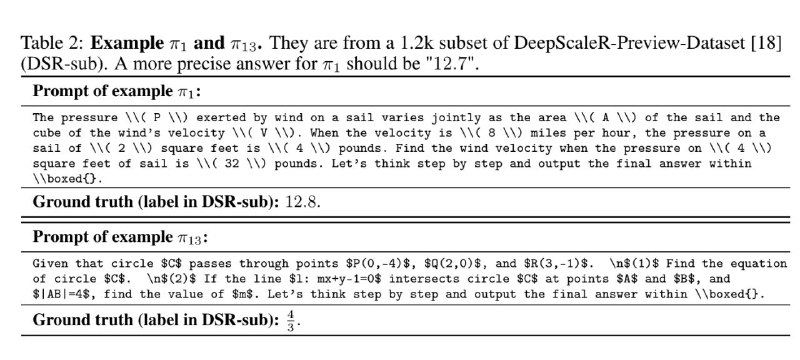

Сами волшебные примеры π номер 1 и 3, кстати, можно посмотреть на рис. 3, а в аппендиксе статьи - увидеть ещё несколько. А еще статья содержит довольно большой раздел с анализом и ablation study.

#объяснения_статей